AI in search: voorbij de hype

Het lijkt erop dat AI de manier waarop zoekmachines werken gaat veranderen: steeds meer ‘conversational search’. Hoe ga je daar als merk of bedrijf mee om en hoe blijf je aanwezig in de zoekresultaten?

Ongeveer een jaar geleden werd ChatGPT gelanceerd. De kracht van Large Language Models kwam plotseling in de handen van iedereen die de moeite nam om te ontdekken hoe deze nieuwe technologie werkt en wat je er mee kunt doen. Daarna ging het snel: in februari 2023 kondigde Microsoft Bing Chat aan, een combinatie van de zoekmachine Bing en ChatGPT. Sinds mei kunnen we deze dienst ook in Europa gebruiken. Microsoft leek daarmee een flinke voorsprong op Google te nemen, maar Google kondigde eerst al zijn eigen chatbot Bard aan (begin 2024 omgeturnd naar ‘Gemini’), en in mei 2023 een eigen variant van de combinatie chat & search: Search Generative Experience (SGE, nog niet in Nederland beschikbaar).

Big tech zit hier dus bovenop. Google, Microsoft en Meta buitelen over elkaar heen met elke maand weer nieuwe coole toepassingen of verbeteringen. Search zal hierdoor blijvend veranderen. Maar hoe precies, en hoe moet jouw bedrijf daarop reageren? Dat beschrijven we in dit artikel.

Hoe zal search veranderen door AI?

De ontwikkelingen in 2023 zijn een versnelling van een beweging die al veel langer gaande is: de toenemende invloed van kunstmatige intelligentie (AI) in search. Zeker Google is daar al jaren mee bezig: denk bijvoorbeeld aan de introductie van Rankbrain in 2015 en BERT in 2019. Deze systemen betekenden een doorbraak in de manier waarop Google de intentie achter een zoekvraag kon analyseren. En daarmee kon Google ook betere antwoorden geven.

Hoewel dit dus al lang speelt bleef de interactie met de zoekmachine ongeveer gelijk: je stelt een vraag, de zoekmachine geeft misschien een direct antwoord (via de zogenaamde featured snippets of andere vormen van rich results) maar meestal zie je direct ook een rijtje met resultaten in beeld waarop je kunt doorklikken. Als je bovenaan de resultaten wordt getoond kun je verwachten dat je flink wat bezoekers trekt.

En dat gaat nu veranderen. We gaan van ‘klassiek zoeken’ naar ‘conversational search’ waarbij de zoekmachine of chatbot altijd met een direct antwoord komt, en waarbij we direct op de eerder gestelde vraag kunnen voortborduren. Je krijgt een gesprek, en dit is anders dan het intikken van ‘keywords’. Een voorbeeld uit de praktijk (antwoorden van de chatbot ingekort omwille van het overzicht):

Gebruiker: “Zijn er overheidssubsidies voor startende ondernemers?”

Chatbot: “Ja, er zijn verschillende regelingen en subsidies beschikbaar voor startende ondernemers in Nederland. Hier zijn enkele van de belangrijkste:”

[daarna volgt een overzicht van 8 regelingen]Gebruiker: “Heb je wat meer info over nummer 4?”

Chatbot: “De startersaftrek is een verhoging van de zelfstandigenaftrek. […]”Gebruiker: “OK, dank en maakt het daarbij nog uit in welke plaats je woont?”

Chatbot: “De startersaftrek is een landelijke regeling en is niet afhankelijk van de plaats waar je woont […]”

Twee zaken zijn belangrijk bij deze verandering in search:

1. Minder bruikbare data voor je search strategie

Door de overgang naar conversational search krijg je een sterke variatie in zoekvragen. De vragen worden veel meer longtail en zullen vaak niet meer herleidt kunnen worden naar een specifiek onderwerp of de achterliggende intentie. Daarnaast is het de vraag welke data over interacties van het publiek met chatbots beschikbaar zal komen.

Een zoekwoord zou dus niet per se het startpunt van je contentstrategie moeten zijn. Belangrijker is om duidelijk te krijgen:

- Wie is je klant

- Welke behoeften heeft die klant

Gebruik daarvoor naast de nog beschikbare zoektermdata bijvoorbeeld eigen klantdata of analyseer de vragen die bij de klantenservice binnenkomen. - Waar bevindt die klant zich

Welke platforms (inclusief je eigen website) zijn het meest geschikt om die behoeften zo goed mogelijk te beantwoorden. Dat kan ook Pinterest of Youtube etc zijn.

Kortom: Doe de juiste dingen voor je klanten, kijk daarbij wat je op je owned kanalen wilt uitdragen en let wat minder op pure search kpi’s als verkeer en posities.

2. Minder verkeer uit organic search

Als Google’s SGE panel wordt ingevoerd zoals ze hem nu testen, dan wordt het een soort ‘featured snippet on steroids’. Er wordt (bijna) altijd een direct antwoord gegeven, waardoor er geen noodzaak is om door te klikken naar een andere website – zelfs als deze in de vorm van bronlinks in het antwoord van de chatbot zijn verwerkt.

Daarnaast is het goed voor te stellen dat de chatbot Gemini (voorheen Bard) voor veel mensen een persoonlijke assistent wordt die heel veel vragen gaat afhangen waarvoor we nu nog naar de zoekmachine gaan. Gemini wordt namelijk volledig geïntegreerd in het Google ecosysteem.

Beide ontwikkelingen zullen gevolgen hebben voor het aantal klikken, en dus de omzet uit organic search. Wees je hiervan bewust en communiceer deze verwachting naar de belangrijkste stakeholders.

Opkomst van AI in search: ‘brand is what AI thinks of you’

En toch. Door de opkomst van chatbots en taalmodellen zal de vraag niet afnemen. Er zijn nog steeds consumenten die een product of een dienst zoeken, of informatie willen. Als organisatie moet je dus blijven werken aan het ontwikkelen van een sterk merk:

- Wanneer gebruikers je kennen, en weten waar je voor staat, is de kans groter dat ze direct naar je website of app komen (en dus de chatbots links laten liggen)

- Een chatbot kan jouw producten, diensten of informatie alleen in het antwoord verwerken wanneer het achterliggende model je merk kent en begrijpt welke oplossingen je biedt.

- Belangrijk hierbij is ook om hands-on ervaring te tonen, en door goede informatie te bieden laten zien dat je een echte expert bent.

- Google’s advies is daarbij: werk aan je EEAT (Experience, Expertise, Authority en Trust) en creëer ‘helpful content’.

Een sterk merk is aanwezig in de Knowledge Graph

Vaak wordt er gezegd: taalmodellen als ChatGPT en Gemini zijn onbetrouwbaar. Dat klopt op dit moment zeker. Er zijn talloze voorbeelden van ‘hallucinerende’ chatbots die een antwoord compleet uit hun duim zuigen – of kleine geniepige foutjes maken die nauwelijks opvallen en zo ongemerkt het informatie-ecosysteem vervuilen.

Maar taalmodellen worden met elke nieuwe versie beter. Google is op dit moment bezig met twee initiatieven die hallucinaties moeten voorkomen:

- Combinatie van LLM’s met ‘verse’ informatie

1. Een nieuw onderzoeksrapport van Google, Refreshing Large Language Models with Search Engine Augmentation (pdf) en de analyses daarvan, laten zien hoe de nauwkeurigheid van LLM-chatbots zoals Gemini kan worden verbeterd door het toevoegen van nieuwe informatie die is opgehaald uit een Google-zoekopdracht in prompts.

2. Door de integratie van Gemini met andere Google-diensten kan Gemini ‘live’ informatie ophalen uit bijvoorbeeld Google zoeken, Google Flights, Youtube, etc. - Combineren van LLM’s met de knowledge graph

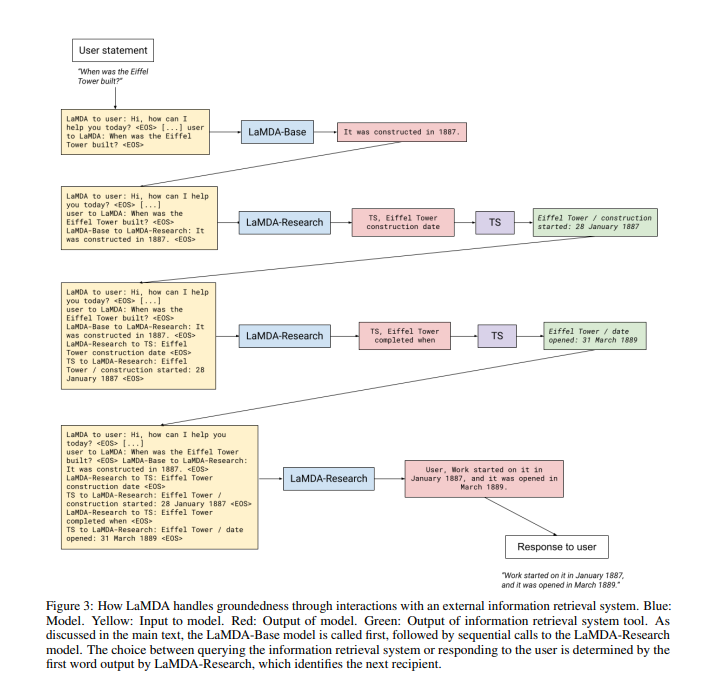

In het artikel LaMDA: Language Models for Dialog Applications (pdf) wordt beschreven hoe de Knowlegde Graph wordt ingezet om de antwoorden van het taalmodel te ‘controleren’ met in de Knowledge Graph vastgelegde kennis. Goed om te weten: LaMDA is het taalmodel waarop Bard gebaseerd is, en Google’s knowledge graph is een mega-database van entiteiten met daarin de onderlinge relaties zijn vastgelegd.

En hierin zit de link tussen een sterk merk en zichtbaar zijn in conversational search: je moet een ‘entiteit’ zijn, dus opgenomen zijn in de Knowledge Graph, om kans te maken in het antwoord van de chatbot voor te komen. Daarbij moet bovendien helder zijn tot welke andere entiteiten jouw merk zich verhoudt. Dus: waar ga je als merk over. Voor het opbouwen van dit soort autoriteit (EEAT) is een brede langetermijnvisie nodig en een scherp oog voor de behoeften van je klanten.

Hoe te beginnen, met hulp van AI

Stel je bent nog geen ‘gevestigd’ merk met een jarenlang track record en duizenden klanten. Wat kun je nu concreet doen om te ‘werken aan je merk’ en dus te werken aan het opbouwen van EEAT voor Search?

Om te beginnen: het lijkt logisch, maar is toch goed om te herhalen dat je geen content op je website moet zetten die alleen door ChatGPT gegenereerd is, zonder dat je deze content zelf hebt nagekeken. De kans dat dit mis gaat is te groot, en de meerwaarde te gering. Taalmodellen kunnen immers alleen trainingsdata op een slimme manier verwerken, ze bieden geen echt nieuwe ervaringen.

Je kunt AI-tools wel op een slimme manier inzetten om het publiceren makkelijker en beter schaalbaar te maken. Google is namelijk niet principieel tegen het gebruik van LLM’s bij het maken van content. Het bedrijf zal alleen wel steeds strenger worden in het beoordelen van kwaliteit. Dat is nodig gezien de verwachte vloed aan door AI gegenereerde content. Vandaar de focus op ‘behulpzame content’ en echte ervaringen met diensten en producten.

Een voorbeeld van het inzetten van AI bij contentproductie (met dank aan SEO & Organic Marketing specialist Chantal Smink, die de methode in haar podcasts beschrijft):

- Inventariseer de aanwezige expertise in je eigen organisatie;

- Vraag aan deze experts wat er speelt op hun vakgebied;

- Neem dit gesprek op met de voice recorder op je telefoon;

- Laat dit transcriberen door bijvoorbeeld Whisper (van de makers van ChatGPT);

- Vat de transcriptie samen met behulp van ChatGPT of Claude;

- Zet dit op je website inclusief het profiel van de expert;

- Gebruik de content ook voor socialemedia-posts: zet langere teksten om in een korte, pakkende tekst speciaal voor social media met behulp van ChatGPT.

Het gaat er hierbij vooral om dat je durft te experimenteren, ook al duurt het de eerste keer lang omdat je alles nog moet uitzoeken. En dit geldt ook voor de thuissituatie. We weten nog niet goed hoe het zoekgedrag gaat veranderen onder invloed van de chatbots. Waarschijnlijk zullen sommige vragen altijd handiger gaan via het klassieke zoeken, en andere vragen via de nieuwe taalmodellen. Van belang is dat je daar als marketeer zelf een idee bij krijgt door het gewoon te doen. Dus pak die telefoon en zet vandaag ChatGPT, Gemini, Bing en Claude op je telefoon als je dat nog niet gedaan hebt.

————————

Dit artikel werd eerder gepubliceerd op Emerce.nl op 1 november 2023: AI in Search: voorbij de hype en in de praktijk).

Update Februari 2024: Verwijzingen naar Google’s Chatbot Bard zijn veranderd in ‘Gemini‘.